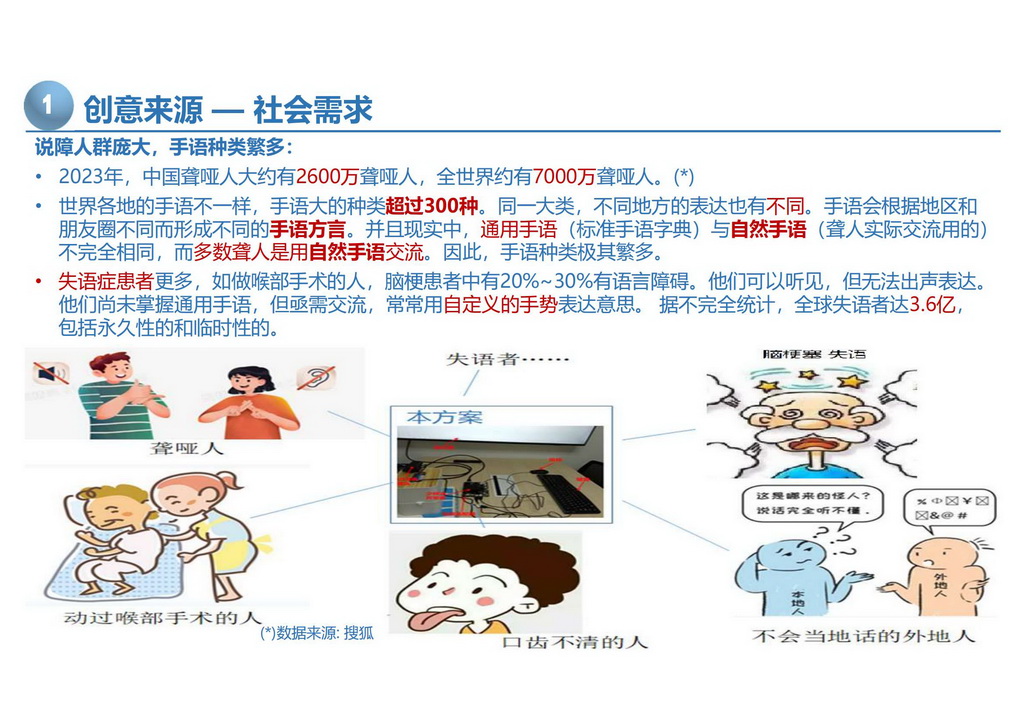

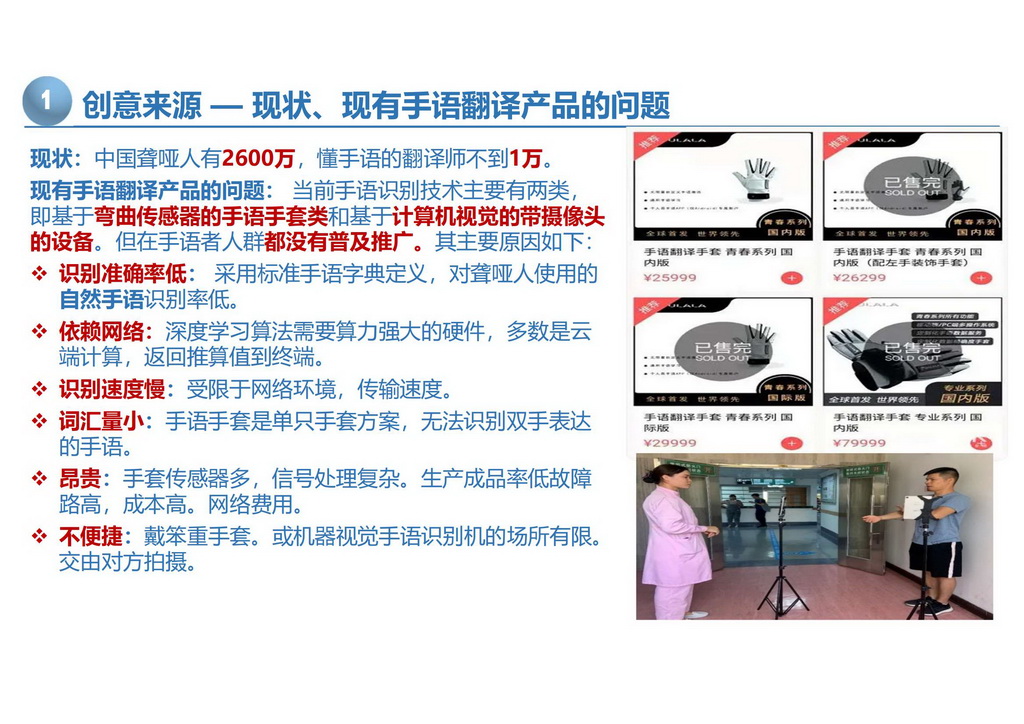

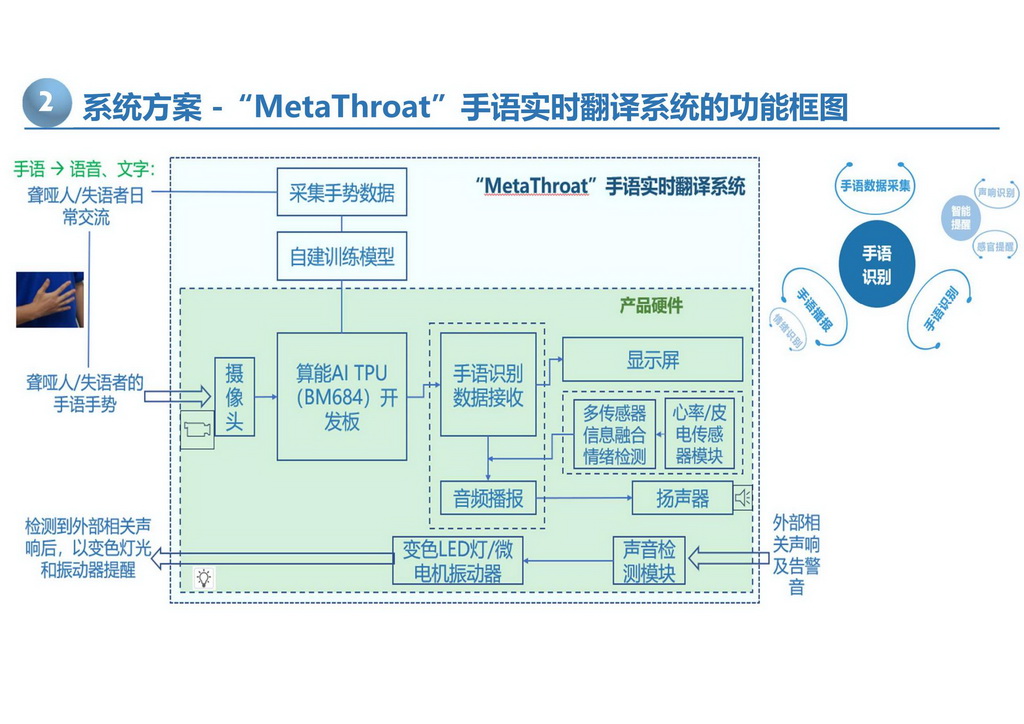

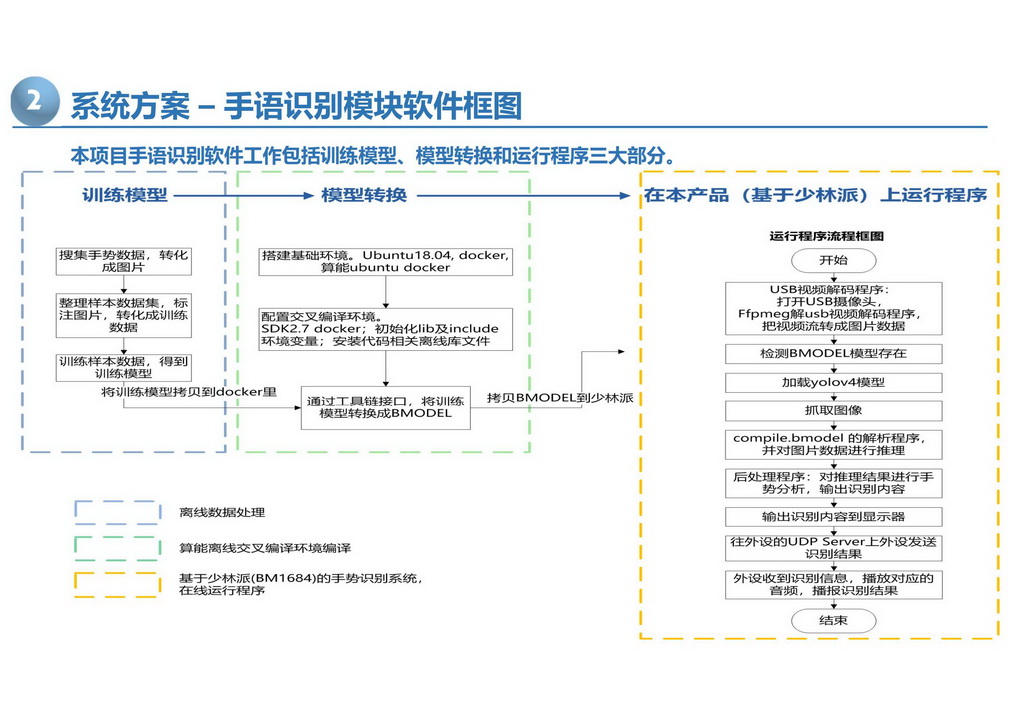

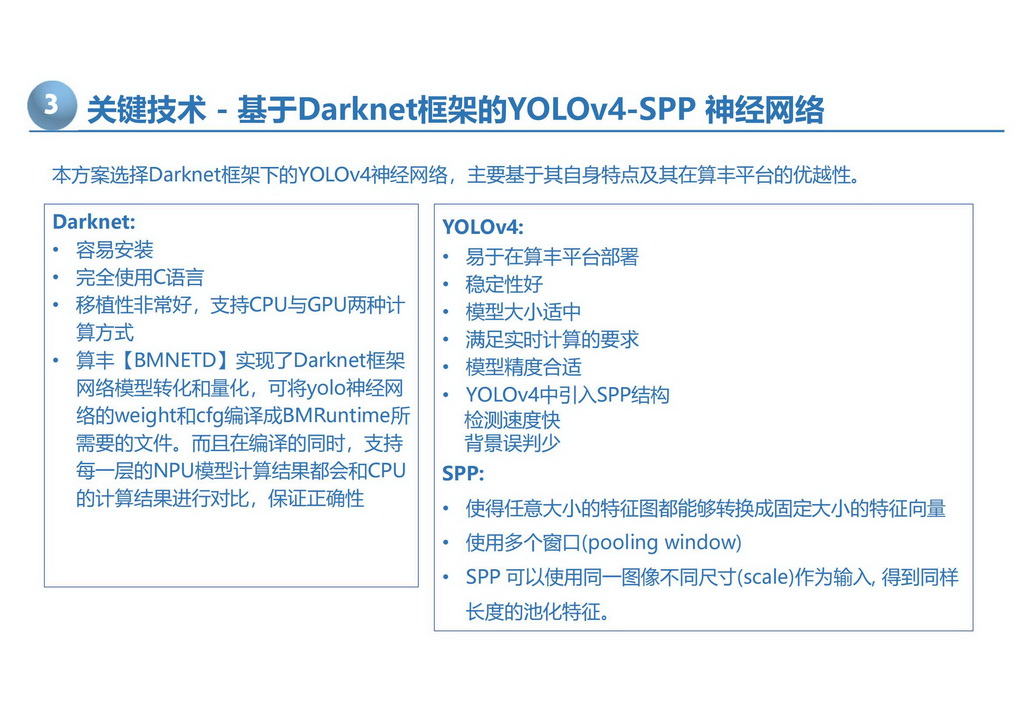

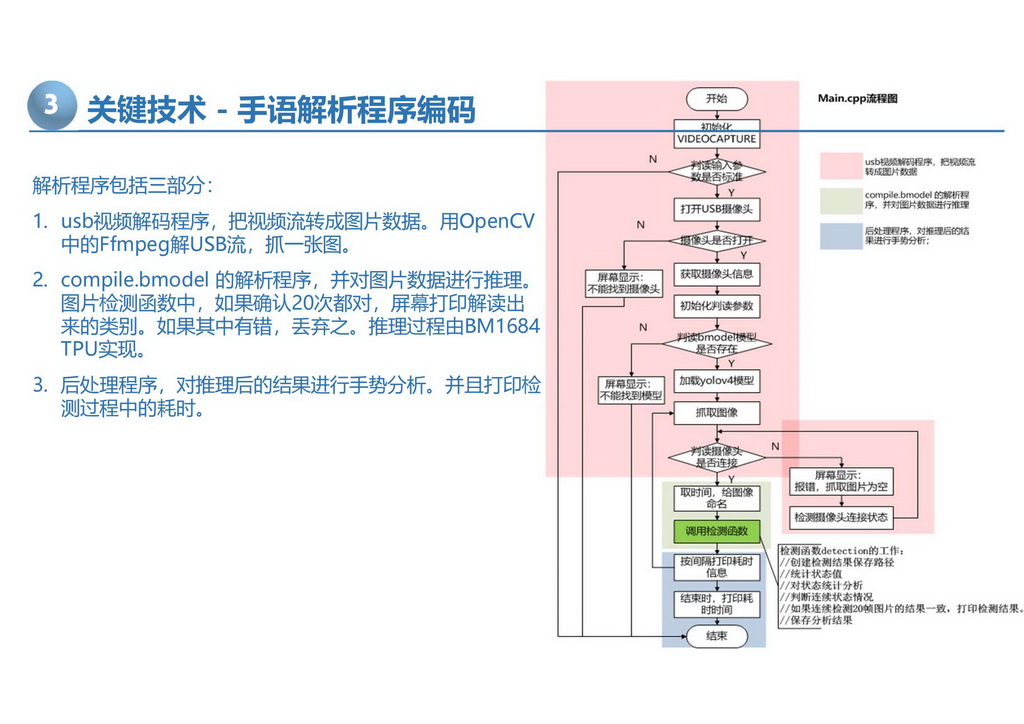

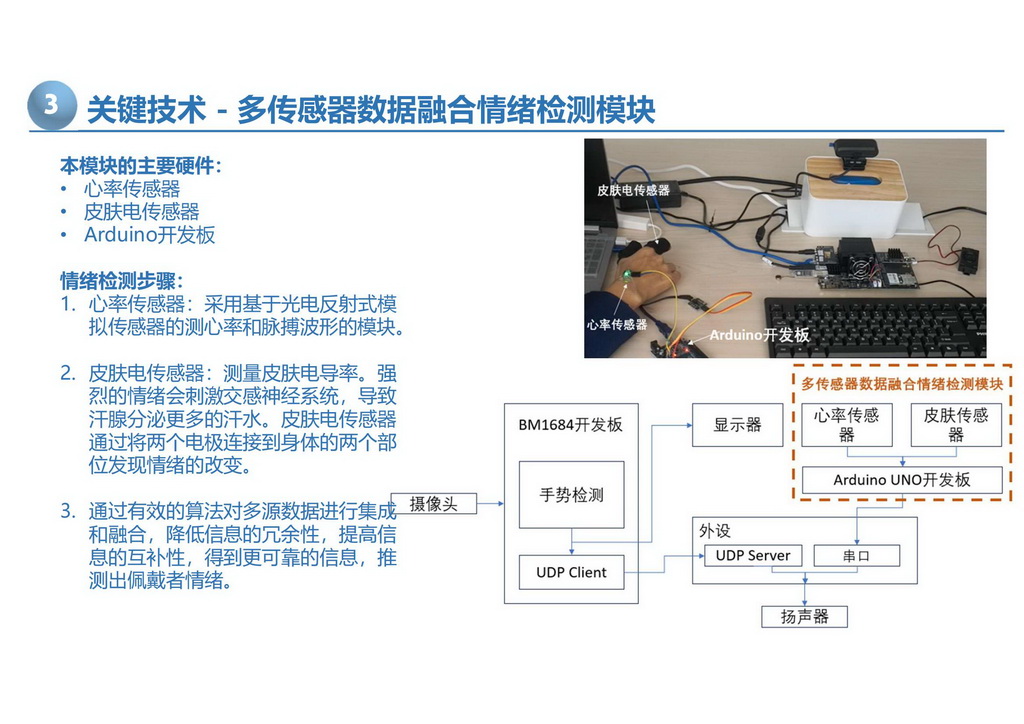

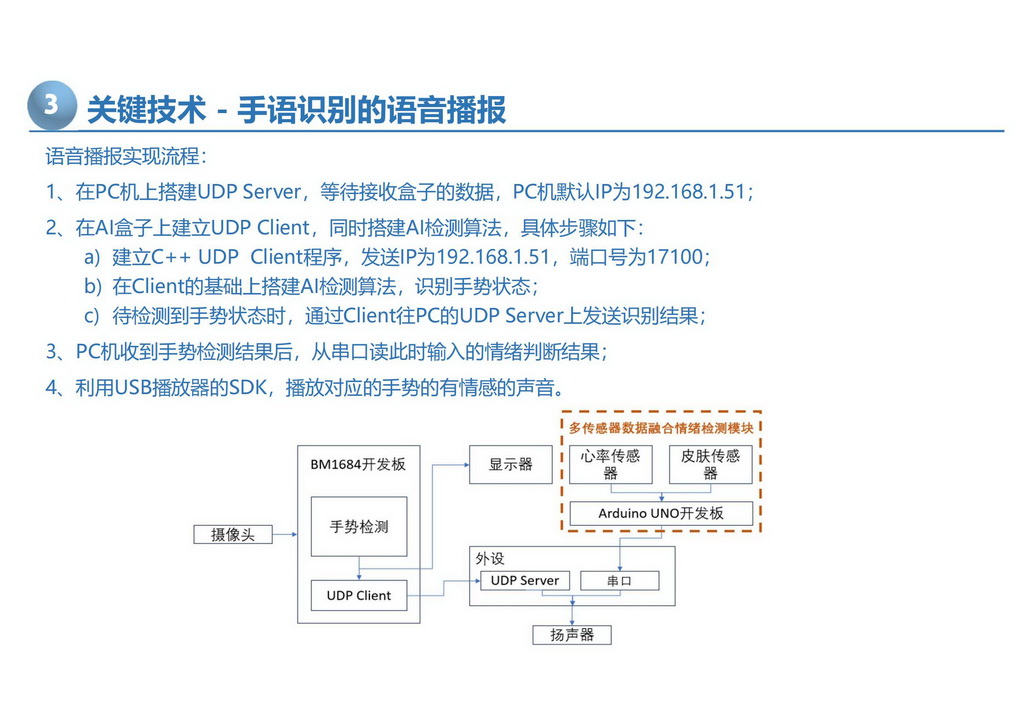

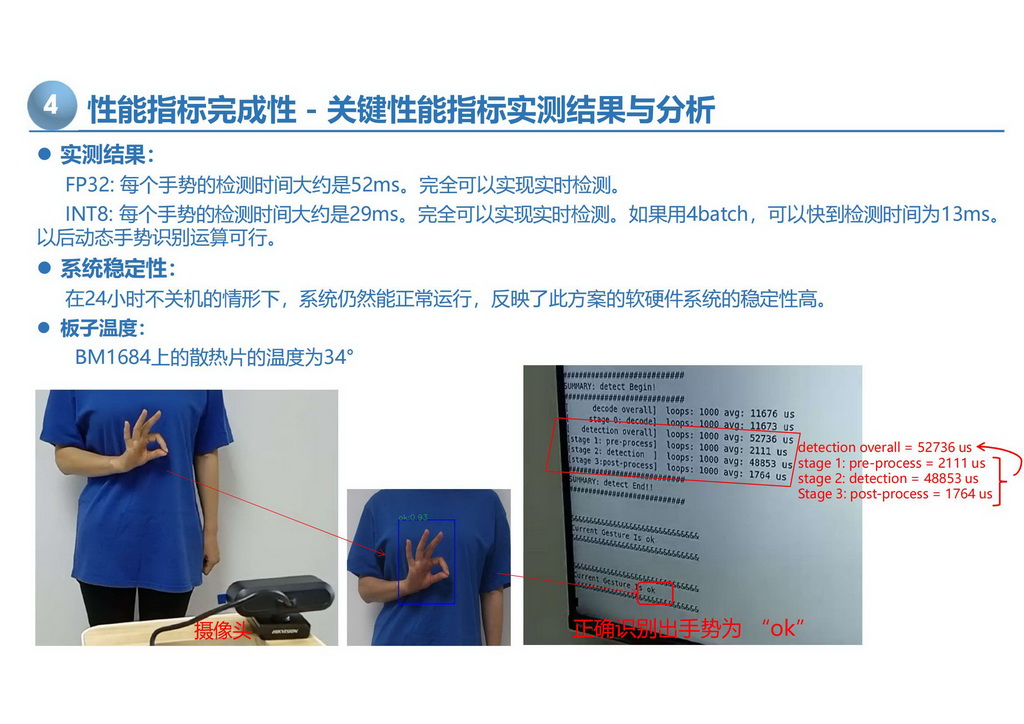

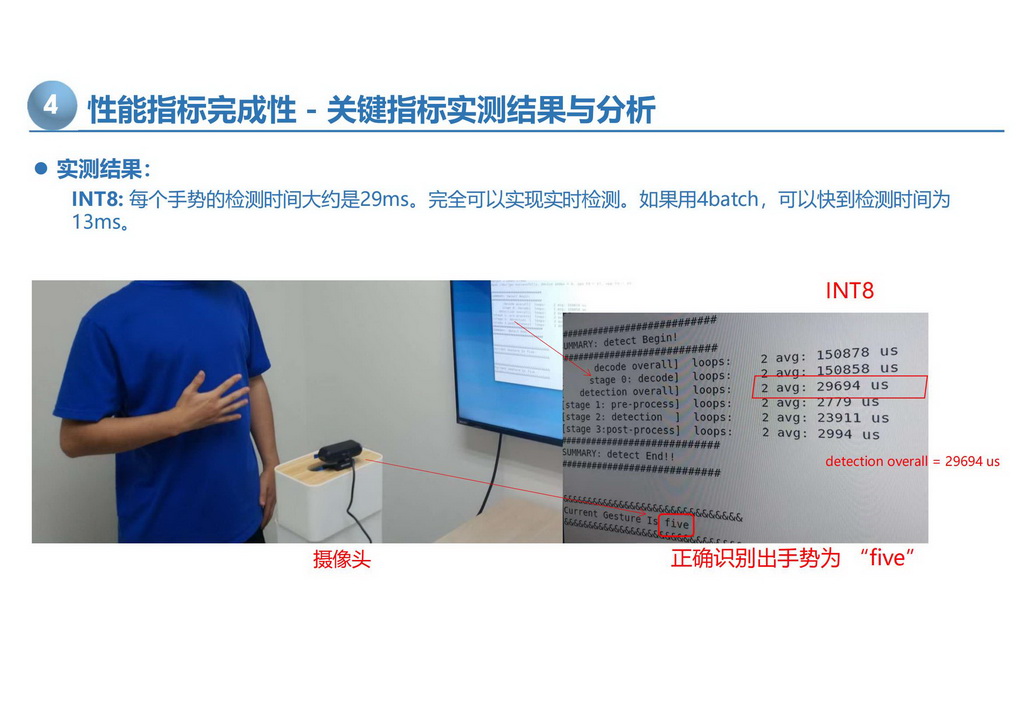

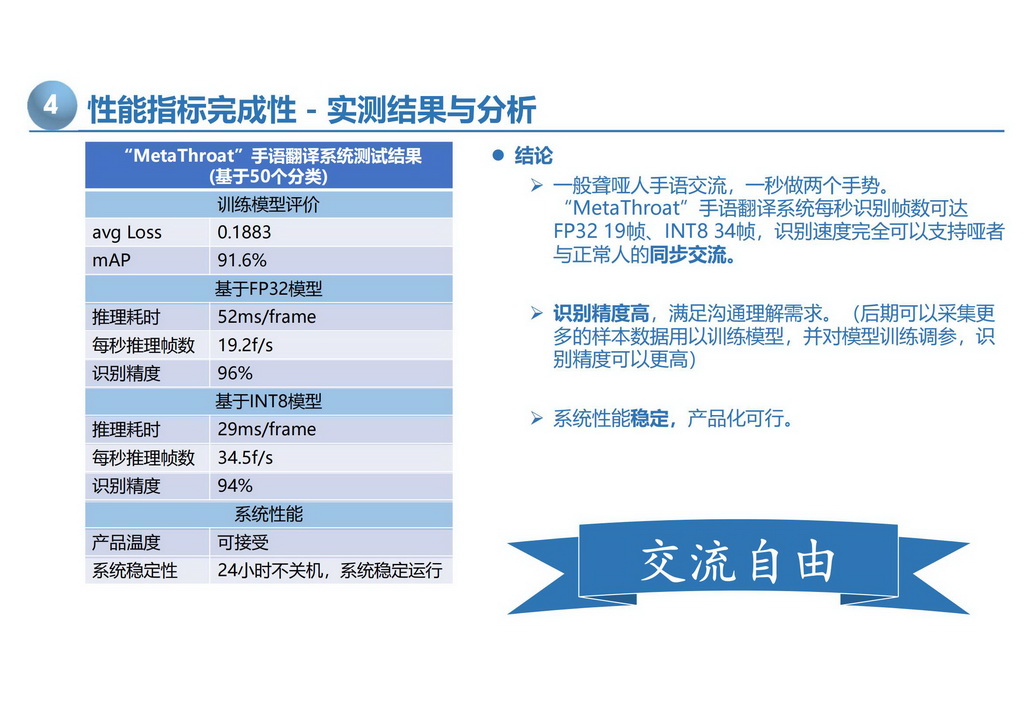

针对目前手语翻译装置的识别准确率低、识别速度慢、依赖网络、装备笨重、故障率高、实用性差、无法普及的问题,本作品应用基于边缘计算人工智能张量处理器TPU、大数据处理、计算机视觉深度学习神经网络、多传感器数据融合、声控技术开发了一种手语识别准确率高、识别速度快、并可针对与标准手语库不同的自有手语的高准确率识别,且不依赖网络的便携式手语实时翻译系统。并对于聋人无法感知外界突然的告警声而易陷入危险的痛点,本产品实现了以振动和多色灯光闪烁的方式进行提醒,具有很高的实用性。 系统开发基于算能边缘计算人工智能处理器TPU( BM1864 )平台,搭载USB摄像头、扬声器、显示屏、心率/皮肤电传感器模块、声音检测模块,及变色LED灯和微型马达提醒器,由数据采集、标注、模型训练、模型转换,OpenCV视频捕捉及解流,YOLOv4-SPP神经网络算法识别手势,UDP推送识别类别,屏幕显示、多传感器数据融合情绪检测、语音播报的UI,及声控灯光及震动提示等部分组成。 其创新点主要体现在: (1)利用TPU BM1684深度学习专有张量处理器的强大算力实现本地计算,速度快且不依赖网络。(2)支持自定义专有手势样本库,解决现实中手语种类多、差异大、识别准确度低下,无法商业化的核心问题,成为行业首创。(3)基于深度卷积神经网络YOLOv4-SPP的目标检测,支持INT和FP32两种精度,可优化识别速度与准确率。(4)通过基于OpenCV的视频捕获及解码,图片解析推理及后处理智能方案减小误检率,大大提高了识别准确率。(5)通过专有训练模型库和通用标准库可切换推理,实现模糊表达的语义智能推送。(6)并且通过搭建UDP用户数据报协议平台,将识别结果的类别上传,通过显示器和声音播报出来,形成友好的UI方案。(7)同时,声音检测模块及多色LED灯和微型马达,对聋人视野外有人与其打招呼或者大声告警时,通过多彩灯光或者振动及时提醒聋人。(8集成多生物传感器模块,实时检测手语者使用手语时的情绪,将手语翻译话语用最匹配情绪的语调语速播报。(9)此系统不依赖网络,算法在本机进行,可适用于无网环境,拓展了用户使用环境,极大的便利了手语用户。(10)此方案是自携式设备,无需旁人协助,使用方便。 本系统拥有自主知识产权,软硬件系统已进入中试阶段,系统实测结果为识别准确度高达96%,识别速度每秒20帧FP32,34帧INT8,几乎可以达到无损翻译个性化手语,值得大大推广。项目查新结果显示暂无同类功能产品。目前一项软著,两项相关专利在申请中。 我们将进一步完善识别算法、情感交互等核心技术,并将产品小型化,增强产品的易用性,尽快将产品推向市场。同时,将与多样化产品供应商合作,如为声音转手势、智能穿戴产品提供技术接口,打造技术二次开发接口平台与大数据平台。并与政府部门合作,提供残疾人保障服务。通过辅以整合技术方案打包提供的模式,构建完整的生态系统。

MetaThroat-基于边缘计算AI TPU、YOLOv4-SPP及多传感器融合技术的手语实时翻译系统

作品名称MetaThroat-基于边缘计算AI TPU、YOLOv4-SPP及多传感器融合技术的手语实时翻译系统

参赛院校华中科技大学/山东大学

指导老师郑俊、鲁赵骏

团队成员季庆林、王玥茗

奖项等级国赛二等奖

竞赛年份2023